Четверг, пять вечера. Начинаю продумывать как проведу этот вечер, заканчиваю дела сегодняшнего дня, но неожиданно к нам в фирму приходит сообщение, которое сразу изменило все мои планы.

Писал нам совершенно неизвестный человек, владелец, как оказалось, интернет магазина. Суть его проблемы была в том, что на протяжении всей последней недели его сайт находился под сильной нагрузкой, как будто вся Россия сразу захотела посмотреть его продукцию. Притом, что количество посещений его сайта ни коим образом не изменилось, да и было довольно низким (примерно 400 человек в сутки).

Надо сказать, что это типичный интернет магазин на 1С-Битрикс редакции Малый бизнес, размещенный на хостинге TimeWeb. Абсолютно стандартная комплектация, мы такие по 2-3 штуки в месяц делаем и ни разу проблем не возникало.

Кроме того он получил три предупреждения от администраторов хостинга о том, что его сайт оказывает слишком большую нагрузку, и что необходимо принять меры, иначе он будет заблокирован. Что в общем то и произошло - его сайт не отвечал. Нужно было срочно принимать меры.

Просмотрев графики нагрузки, прочитав его переписку с администраторами хостинга, решил я посмотреть на файл логов, который упоминался в переписке. Файл меня сильно озадачил хотя бы тем, что размер его был 250Мб.

А дальше началось, все самое интересное: логи рассказали, что практически все ошибки идут от ботов поисковиков (Яндекс, Google, Bing). И самое интересное, что они переходят по всем ссылкам, в том числе по ссылкам: купить, в корзину и так далее. В секунду по 4-6 ошибок. Вопрос возник сам собой: какого черта?

И действительно, какого черта поисковики проявляют такую активность и лезут куда не следует? Ответ оказался прост и банален: файл robots.txt, при просмотре которого я был в тихом шоке. Он был пуст! Ну не совсем пуст, он закрывал лишь папку /bitrix/.

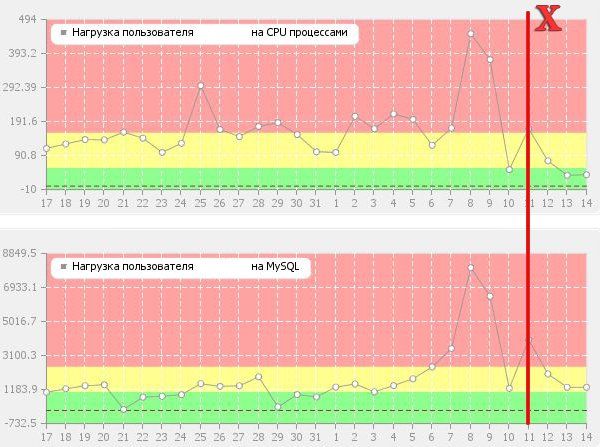

Что ж, прошло три дня, картина представлена на графике выше. Х - это день обращения к нам. Мы видим резкое падение нагрузки: процессор почти не напрягается, база данных работает в нормальном темпе.

С этим клиентом мы еще будем работать и довольно долго, нужно будет провести большое количество других работ, в том числе и по снижению нагрузки, и по оптимизации для поисковиков. Главное то, что проблема была найдена и решена.

На наш вопрос: Кто же занимается Вашим продвижением? Что за фирма то такая? В ответ мы услышали: Да к я сам....

Ну что хочется посоветовать:

Программистам и SEO оптимизаторам: более качественно выполнять свою работу. (Спасибо одному хорошему SEO-оптимизатору, который подсказал про существование параметра Crawl-delay в robots.txt)

Заказчикам и клиентам: не нужно самим проводить работу, в которой Вы плохо разбираетесь. Доверьте ее профессионалам! Ведь неосторожными действиями можно не только навредить продвижению сайта, но и полностью положить сервер.